măsură informații Sintaxă

Fig. 1.1. măsuri de informare

măsură Sintaxa funcționează cantitatea de date și cantitatea de informații Ia. exprimat în termeni de entropie (conceptul de incertitudine a sistemului).

măsură semantică operează cantitatea de informații exprimate în ceea ce privește volumul său și gradul de incluziune.

măsură Pragmatic determinată de utilitatea sa, exprimată prin efecte economice relevante.

măsură informații Sintaxă

Această măsură a cantității de informații operează cu informații non-personale, nu exprimă relația semantică a obiectului.

Astăzi, cele mai cunoscute următoarele metode pentru informațiile de măsurare cantitativă: volum, entropia, algoritmică.

Volumul este modul cel mai simplu și brut de informații de măsurare. Informațiile relevante cuantifica în mod natural numit volumul de informații.

Cantitatea de informații - acesta este numărul de caractere din mesaj. Deoarece același număr poate fi scris în mai multe moduri diferite, de exemplu, folosind alfabete diferite, cum ar fi douăzeci și unu - .. 21- XXI- 11001, această metodă este sensibil la forma de prezentare (înregistrare) mesaje. În calcul toate (numere, text, grafice) prelucrate și stocate informații, indiferent de natura acesteia reprezentate în formă binară (folosind alfabetul este format din doar două simboluri „0“ și „1“).

În unitatea de notație binară - bit (bit - binar cifre - bit).

În teoria informației, bitul - cantitatea de informații necesare pentru a distinge între două mesaje la fel de probabile; și un pic de calcul numit cel mai scăzut „porțiune“ de memorie necesară pentru a stoca una dintre cele două personaje „0“ și „1“ este utilizat pentru a reprezenta date și comenzi intraengine. Acest lucru este prea mic o unitate de măsură, utilizate adesea în unități mai mari de practica - bytes - care este egal cu 8 biți necesari pentru a codifica oricare dintre cele 256 de caractere ale calculatorului tastatură alfabet (256 = 2 8).

De asemenea, utilizate pe scară largă de unități și mai mari de informații derivate:

1 kilobyte (kB) = 1024 octeți = 2 10 octeți;

1 Megabyte (MB) = 1024 = 2 Kbytes 20 octeți;

1 Gigabyte (GB) = 1024 MB = 2 30 octeți.

Recent, datorită creșterii volumului de informații prelucrate incluse în folosirea derivaților următoarele unități:

1 terabytes (TB) GB = 1024 = 2 40 octeți;

1 Petabyte (PB) TB = 1024 = 2 50 octeți.

În unitatea de sistem număr zecimal - dit (decimal).

Mesaj în sistem binar în formă de cod binar opt biți 1011 1011 are volum de date Vd = 8 biți.

Mesaj în sistem zecimal în formă de număr de șase biți 275903 are un volum de biți de date Vd = 6.

În teoria informației, entropie și codificare a adoptat o abordare a mass-media de măsurare. Obținerea de informații cu privire la orice sistem este întotdeauna asociat cu gradul de ignorant-Ness a destinatarului cu privire la starea sistemului. Această metodă de măsurare se bazează pe următorul model.

Să presupunem că înainte de informațiile pe care consumatorul are unele informații preliminare (a priori) despre sistemul # 945;. După primirea mesajului destinatarului b a achiziționat câteva informații suplimentare I (b), reducând ignoranța. Aceste informații sunt, în general, de încredere și exprimă probabilitatea cu care se așteaptă acest lucru sau acel eveniment. O măsură comună de incertitudine (entropie) se caracterizează printr-o combinație de dependență matematică a acestor probabilități. Cantitatea de informații din mesajul este determinată de modul în care această măsură va scădea după primirea mesajului.

Astfel, inginerul american R. Hartley (1928), procesul de obținere a informațiilor cu privire la alegerea uneia dintre posturile finale set de N mesaje la fel de probabile preasignată, iar cantitatea de informații i, conținute în mesajul selectat, determină modul în care logaritmul binar al N (formula Hartley):

.

Să presupunem că trebuie să ghicească numărul de unul dintr-un set de numere una la sută. Conform formulei lui Hartley poate calcula cât de mult informațiile pe care le necesită :. t. e. Mesajul conține ghici corect numărul de informații de aproximativ 6.644 de unități de informații.

Alte exemple de mesaje în mod egal:

1) pentru a arunca o monedă „a scăzut cozi“, „a scăzut Eagle“;

2) pe pagina cărții „un număr par de litere“, „număr impar de litere.“

Este imposibil să se răspundă fără echivoc la întrebarea dacă posturile sunt la fel de probabil „primul venit din ușile femeii de construcție“ și „primul care a ieșit din ușile clădirii unui om.“ Totul depinde de ce fel de clădire este în cauză. Dacă este, de exemplu, stația de metrou, probabilitatea de primul pentru a ieși din uși este aceeași pentru bărbați și femei, iar în cazul în care este o cazarmă militară, pentru bărbați, această probabilitate este mult mai mare decât în cazul femeilor.

În sensul acestui tip de un om de știință american Klod Shennon a propus în 1948 o formulă diferită pentru determinarea cantității de informații care să ia în considerare posibila probabilitatea inegală a mesajelor în setul (formula Shannon):

,

în cazul în care - probabilitatea ca acesta este mesajul i-lea este alocat la setul de mesaje N.

Este ușor de văzut că, dacă probabilitatea ... sunt egale, atunci fiecare dintre ele este egal cu formula Shannon, și este convertit în formula Hartley.

Pe lângă cele două abordări luate în considerare pentru a determina cantitatea de informații, există alte. Este important să ne amintim că orice rezultate teoretice sunt aplicabile numai la un anumit interval de cazuri prezentate ipotezele inițiale.

În teoria informației algoritmice (teoria secțiunii algoritmi) propune o metodă algoritmică de evaluare a informațiilor în mesaj. Orice post poate fi atribuită caracteristica cantitativă reflectând programului de complexitate (mărime), care îi permite să producă.

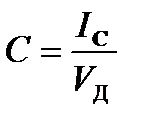

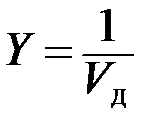

Coeficientul (grad) informativeness (concizie) Mesajul este determinat de raportul dintre volumul total de informații al datelor:

Odată cu creșterea Y redus volumul de muncă pe transformarea informațiilor (date) în sistem. Prin urmare, trebuie să depună eforturi pentru a îmbunătăți conținutul de informații, care a dezvoltat metode speciale de codificare optimă a informațiilor.

1.4.2.2 măsură informații semantice

Semantica - știința sensului, informații de conținut.

Pentru a măsura cantitatea de informație semantică folosind conceptul de „tezaur utilizator“ t. E. totalitatea informațiilor disponibile utilizatorului sau sistemului.

Fig. 2. 1. Determinarea numărului de informații semantice percepute de către utilizator, din tezaurul său IC = f (Sp)

Luați în considerare două cazuri extreme, atunci când numărul de IC informații semantice este 0:

- în cazul în care utilizatorul nu acceptă, nu înțelege informațiile primite;

- în cazul în care utilizatorul cunoaște și informațiile primite nu-i convine.

Numărul maxim de informații semantice achiziții de consum, la coordonarea conținutului semantic S cu tezaurul dvs. (), atunci când informațiile primite este de înțeles pentru utilizator și poartă-l necunoscute anterior (lipsește în tezaur său) informații.

Prin urmare, cantitatea de informație semantică și de noi cunoștințe în mesajul primit de către utilizator este magnitudinea relativă.

Măsura relativă a cantității de informație semantică poate fi meaningfulness coeficient C, definit ca raportul dintre cantitatea de informație semantică volumul său: